Ce que signifie réellement une IA responsable

L’IA responsable ne se limite pas à optimiser des modèles ou à réduire les coûts d’infrastructure. Elle vise à construire une adoption durable de l’intelligence artificielle. Cela signifie concevoir des systèmes d’IA intégrés aux opérations quotidiennes, adoptés par les équipes et capables d’évoluer avec l’organisation dans le temps.

Concrètement, une IA responsable est une IA capable de résister à la complexité du terrain.

Les recherches mondiales de McKinsey sur l’adoption de l’IA montrent que si une majorité d’entreprises déclarent utiliser l’IA dans au moins une fonction, beaucoup moins parviennent à générer un impact significatif à l’échelle de l’entreprise. L’écart ne s’explique pas par la faiblesse des algorithmes, mais par la difficulté à intégrer l’IA dans les workflows et les processus décisionnels.

Dans son rapport Superagency in the Workplace, McKinsey souligne également que l’IA crée de la valeur mesurable lorsqu’elle améliore la manière dont les collaborateurs travaillent, plutôt que lorsqu’elle s’ajoute comme une couche technologique déconnectée.

L’IA responsable est donc indissociable d’une adoption responsable et durable.

Pourquoi l’adoption de l’IA échoue après la phase pilote

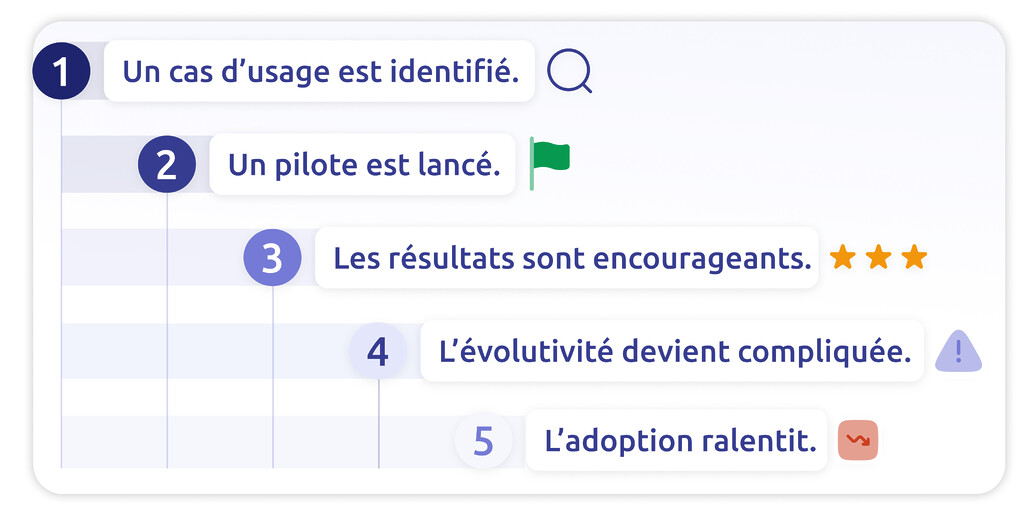

Le cycle des initiatives IA qui échouent est étonnamment similaire. Un cas d’usage pertinent est identifié. Un pilote est lancé. Les premiers résultats sont encourageants. La phase de déploiement démarre. Les résistances apparaissent. La complexité augmente. L’adoption ralentit. Puis, progressivement, le projet disparaît des priorités.

Le problème est rarement technique. Il est avant tout organisationnel.

Trop souvent, l’IA est superposée aux systèmes existants au lieu d’y être intégrée. Les équipes doivent consulter de nouveaux tableaux de bord, naviguer entre plusieurs interfaces ou adapter des processus parallèles. Au lieu de simplifier le travail, l’IA le complexifie. Lorsque les frictions augmentent, la confiance diminue. Et lorsque la confiance diminue, l’adoption s’effondre.

Le Boston Consulting Group confirme que si la majorité des organisations expérimentent l’IA, seule une minorité parvient à créer de la valeur à grande échelle. Les freins principaux concernent la gouvernance, la refonte du modèle opérationnel et la conduite du changement, bien plus que la sophistication des modèles.

Dans son étude Are You Generating Value from AI? The Widening Gap, le BCG explique que les entreprises qui obtiennent un réel impact considèrent l’IA comme une transformation organisationnelle, et non comme un simple déploiement technologique.

L’IA responsable commence là où la culture du pilote s’arrête.

Le socle humain d’une IA responsable

Dans les centres de contact, l’adoption de l’IA dépend des personnes qui l’utilisent au quotidien. Les agents, les superviseurs et les managers opérationnels décident, en pratique, si l’IA devient un véritable assistant ou une fonctionnalité ignorée.

Si les équipes terrain ne comprennent pas comment l’IA soutient leurs objectifs, elles reviendront à leurs habitudes. Si l’IA perturbe les workflows établis sans bénéfices clairs, la résistance s’installe. C’est pourquoi l’adoption de l’IA par les collaborateurs doit être traitée comme une priorité stratégique et non comme une étape secondaire.

Une IA responsable repose sur une approche profondément humaine. Elle exige de la transparence, de la formation et une communication claire sur la manière dont l’IA améliore la performance sans menacer les rôles. Les études sur les freins à l’adoption de l’IA montrent de manière récurrente que l’absence de gouvernance claire, le faible engagement des utilisateurs et la résistance organisationnelle freinent davantage les projets que les limites techniques.

L’adoption ne se décrète pas. Elle se construit.

Le rôle des “Glue Employees” dans la conduite du changement

Dans chaque initiative d’IA responsable qui réussit, on retrouve des profils capables de faire le lien entre innovation et opérations. Ils ne portent pas forcément de titres exécutifs, mais ils jouent un rôle décisif dans la conduite du changement.

Ce sont les “Glue Employees”.

Ces collaborateurs traduisent la stratégie en actions concrètes. Ils testent les nouvelles fonctionnalités, partagent des retours, rassurent les collègues sceptiques et démontrent la valeur dans les tâches du quotidien. Leur crédibilité tient au fait qu’ils sont reconnus et respectés par leurs pairs.

Sans ces relais internes, l’IA reste une initiative portée par la direction. Avec eux, elle devient une réalité opérationnelle.

Une IA responsable s’appuie sur ces ambassadeurs. La technologie se diffuse plus vite lorsque la conviction se propage naturellement au sein des équipes.

Dans les centres de contact, l’IA doit être intégrée, pas ajoutée

L’un des principaux freins à l’adoption de l’IA dans les centres de contact réside dans une mauvaise intégration. Lorsque les outils d’IA obligent les agents à changer de plateforme, à dupliquer la saisie des données ou à interpréter des suggestions sans contexte, l’efficacité diminue au lieu d’augmenter.

Une IA responsable dans les centres de contact suppose que l’intelligence artificielle soit pleinement intégrée à l’écosystème existant. Les suggestions en temps réel apparaissent directement dans l’interface agent. Les résumés automatiques réduisent le travail après appel sans ajouter d’étapes supplémentaires. Les insights qualité sont intégrés aux workflows de supervision, et non diffusés via des outils de reporting séparés.

L’objectif est simple : réduire la charge cognitive.

Des expérimentations menées sur l’IA générative en environnement professionnel montrent que les gains de productivité sont réels lorsque l’IA est intégrée aux processus de travail, et non proposée comme une application isolée.

Si l’IA ne s’aligne pas sur la manière dont les équipes travaillent déjà, son adoption restera limitée. L’IA responsable implique cette cohérence.

Une IA responsable exige un écosystème technologique cohérent

Si l’adoption humaine est essentielle, l’IA responsable repose également sur une architecture technique solide. De nombreuses organisations accumulent des solutions d’IA déconnectées au fil du temps, créant des flux de données fragmentés et des systèmes redondants. Cette approche en patchwork accroît la complexité et limite l’évolutivité.

Une IA responsable doit présenter un écosystème unifié dans lequel modèles, données et workflows fonctionnent de manière cohérente. Elle nécessite une infrastructure capable d’évoluer avec la croissance de l’entreprise et des solutions conçues pour fonctionner ensemble, et non en silos.

Le rapport Closing the AI Impact Gap du BCG souligne que les entreprises qui génèrent une valeur mesurable grâce à l’IA la considèrent comme une décision de plateforme, et non comme une collection d’expérimentations.

Dans les centres de contact, cela signifie que la téléphonie, le CRM, l’analytics et les capacités d’IA doivent opérer dans un environnement cohérent. La scalabilité repose sur cette intégration.

Les boucles de feedback, moteur de l’adoption durable

Une IA responsable n’est pas figée. Elle s’améliore en continu.

Les systèmes d’IA qui intègrent des retours structurés des agents et des superviseurs deviennent plus précis, plus pertinents et plus crédibles. Le monitoring continu, l’ajustement des modèles et l’alignement avec les KPI opérationnels transforment l’IA en capacité dynamique plutôt qu’en outil statique.

Sans boucle de feedback, l’IA stagne. Sans évolution, la confiance s’érode. L’IA responsable repose sur des systèmes conçus pour apprendre de l’usage réel et s’adapter en conséquence.

La confiance est le véritable fondement d’une IA responsable.

L’IA responsable, avantage stratégique des centres de contact

Les centres de contact figurent parmi les environnements opérationnels les plus humains d’une organisation. La performance y dépend de l’empathie, de la réactivité et de la cohérence. L’IA peut renforcer ces dimensions, à condition d’être adoptée à grande échelle.

Dans les centres de contact, l’IA responsable donne du pouvoir aux agents au lieu de les remplacer. Elle améliore la performance sans accroître la complexité. Elle soutient les objectifs opérationnels tout en respectant l’expertise humaine.

Le succès à long terme ne dépend pas du modèle d’IA le plus avancé. Il dépend d’une adoption profonde et durable par l’ensemble des équipes.

De l’expérimentation à l’IA responsable

L’IA responsable ne consiste pas à multiplier les pilotes. Elle consiste à concevoir des stratégies d’adoption qui s’inscrivent dans la durée.

Elle exige un alignement du leadership, une communication claire, une conduite du changement solide, des Glue Employees capables de diffuser la conviction, des workflows intégrés, une technologie scalable et des boucles de feedback continues.

Lorsque ces éléments convergent, l’IA cesse d’être un projet. Elle devient un mode de fonctionnement.

C’est cela, l’IA responsable.

Prêt à construire une IA responsable ?

L’IA responsable ne se résume pas à lancer des pilotes.

Il s’agit de bâtir une adoption durable de l’intelligence artificielle.

Si vous souhaitez comprendre comment passer de l’expérimentation à une IA dans les centres de contact réellement scalable, et comment favoriser une adoption concrète par les équipes, téléchargez notre ebook :

Découvrez comment adopter une IA responsable